Singularidad: ¿se saldrá la inteligencia artificial de nuestro control?

En física, una singularidad es un punto en el espacio-tiempo donde se produce un evento que no cumple ninguna de las leyes físicas previstas para el mismo.

A nivel informático, la singularidad sería aquel evento en el que los sistemas no solo no se comportan como está previsto, sino que, súbitamente, ofrecen una respuesta no esperada basada en un criterio propio.

En este punto, cualquier predicción sobre lo que ocurrirá después fallaría. Y cuando el ser humano no puede, ni siquiera, controlar de forma imaginaria los posibles escenarios futuros, se comienza a inquietar.

Voces de alarma

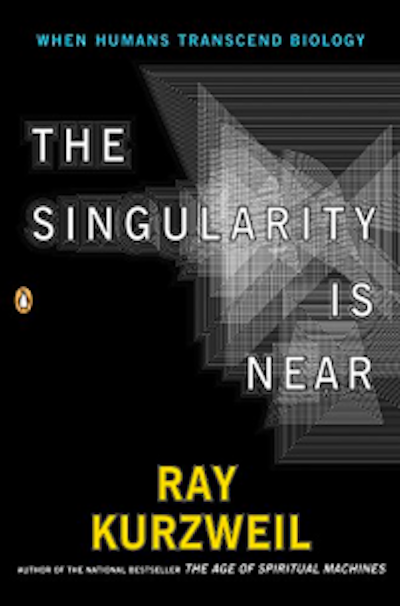

Para algunos, no es algo lejano. Por ejemplo, el informático futurista Ray Kuzweil, en una entrevista del 2023, aseguraba que el comienzo de la singularidad tendría lugar en 2045.

Mientras, investigadores de gran prestigio, como Geoffrey Hinton, Yoshua Bengio o Stuart Russell aparecen en los medios de comunicación alertándonos de un grave peligro emergente. Incluso uno de los fundadores de OpenAI, Sam Altman, ha llegado a pedir ante un comité del Senado de los Estados Unidos regular los avances de la inteligencia artificial (IA). ¿Realmente es tan preocupante?

La consciencia en las máquinas

La clave de esta inquietud no está tanto en la singularidad, sino en el paso previo necesario para llegar a ella: la creación de una nueva inteligencia artificial general (AGI, por sus siglas en inglés).

Nos referimos a aquella capaz de igualar a la inteligencia humana en sus procesos tanto cognitivos como relacionales, es decir, una IA capaz de dominar las 8 inteligencias múltiples.

De conseguirse, conformaría la tercera gran revolución en la historia de la IA. Tanto es así que existe una carrera geopolítica silenciosa al respecto de quién será el primero en conseguirla.

¿Inteligencia artificial con intenciones?

Aunque los sistemas de IA actuales, según algunos, puedan dar signos de cierta autoconsciencia –como publicó Blake Lemoine en sus “conversaciones” con LamDa o desde Microsoft a través de una publicación– las IA actuales, no “saben” o no son “conscientes” de lo que están generando.

Son solo buenos predictores de píxeles o de palabras, en base a los ítems anteriores, pero siempre en base a un entrenamiento. No pueden “reflexionar” si esas inferencias son correctas, ni son capaces de formular hipótesis sobre las razones de sus propias conclusiones.

Por lo tanto, tampoco son conscientes de su posicionamiento subjetivo ante las mismas. Simplemente, son muy buenas dando respuestas, pero no son capaces de desarrollar las preguntas adecuadas. Todavía.

La clave, imitar al cerebro humano

La primera revolución en el mundo de la IA vino dada por la implementación simplificada, in silico, del modelo de una neurona natural. En 1906, Frank Rosenblatt diseñó el “perceptrón”, la base de todas las redes artificiales actuales.

La segunda revolución en la IA vino, una vez más, al “copiar” una topología de redes neuronales humanas en un programa. Esta vez fue Kunihiko Fukushima quien, en 1980, inspirado en el modelo propuesto por los premios Nobel Hubel y Wiesel (1959), desarrolló la base de las actuales redes convolucionales y profundas.

Fue el nacimiento de una revolución tecnológica sin precedentes, mejorada de forma progresiva por parte de los informáticos Jan LeCun y de Dan Ciresan.

Actualmente, dentro de la neurocomputación, se está trabajando en una segunda versión de estas redes, muy prometedoras, denominadas redes neuronales de impulsos o spiking.

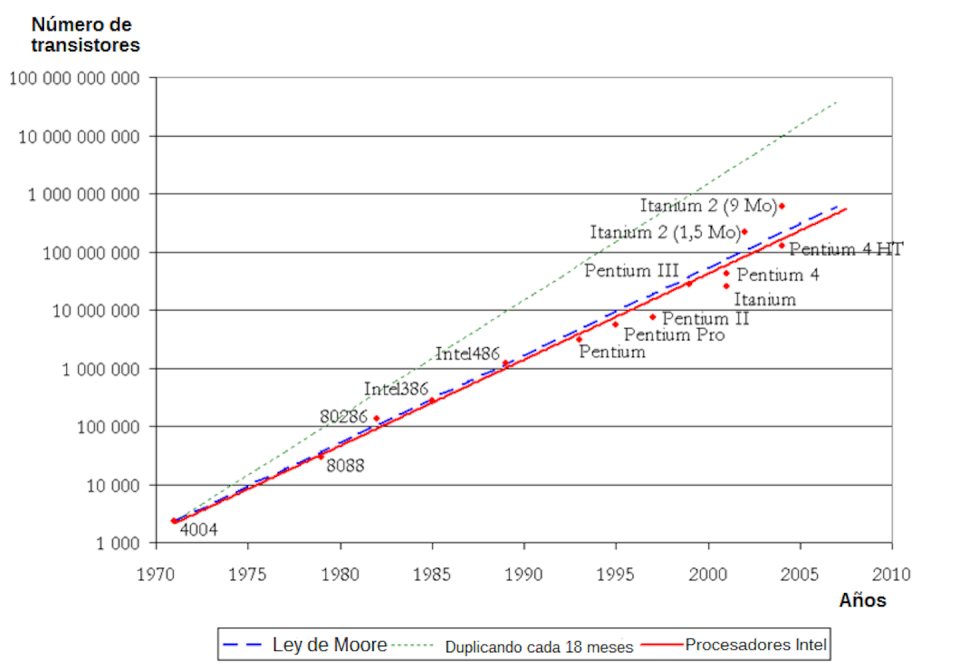

Para llegar a una IA general –o AGI–, debemos ir de la mano de la neurocomputación, investigando sobre la topología de una red artificial capaz de generar reglas formales, matemáticas, semánticas o lingüísticas, que formule hipótesis sobre las respuestas obtenidas por la IA tradicional. Pero el nivel de computación actual ya ha llegado a su límite para este objetivo.

El mismo Moore pronosticaba que, en 2021, una nueva tecnología vendría a suplir su actual modelo de crecimiento computacional. Y acertó.

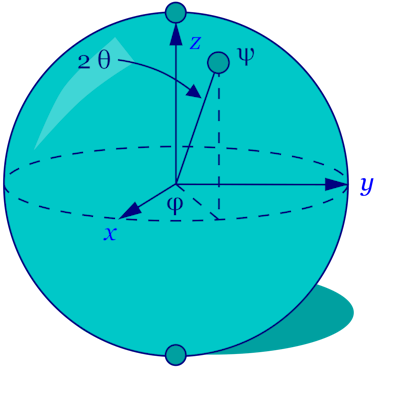

Esta tecnología es la computación cuántica. Con solo 40 cúbits, podemos procesar por “fuerza bruta” y en paralelo, tantos estados computacionales como neuronas tiene nuestro cerebro.

Además, ciertas teorías indican que, no solo a nivel atómico, sino también a nivel cerebral, existe un comportamiento cuántico en la inferencia y comunicación entre neuronas de zonas no adyacentes.

El premio nobel de física Roger Penrose es uno de los mayores defensores de esta teoría, que se ve complementada por otros enfoques, como la teoría de Kauffman o la teoría de Bleck y Eccles.

¿Los primeros signos de singularidad?

Existen ya primeras aproximaciones a la AGI reflexiva, como los sistemas MuZero o LIDA. Centros de investigación muy punteros, como I3B (Ibermática Fundazioa), llevan años investigando en el desarrollo de una AGI basada en la inclusión de una topología de grafos semánticos dentro de sistemas profundos.

Esto supone unir los mundos de la neurocomputación, la computación cuántica y la inteligencia artificial en un trabajo multidisciplinar entre neurocientíficos, humanistas, antropólogos, ingenieros, informáticos, científicos de datos y programadores cuánticos.

En este contexto, una nueva AGI obligaría a implementar, necesariamente, una autoconsciencia artificial. El país que lo consiga liderará una cuarta revolución tecnológica consolidando una industria increíblemente rentable que lo posicionará como proveedor a nivel mundial. España posee de sobra capacidades y talento en IA, cuántica y en neurocomputación para conseguirlo.

Por otro lado, será el nacimiento de nuevos sistemas capaces de ayudarnos a comprender mejor nuestro universo y a nosotros mismos, proponiendo preguntas que, quizás, jamás nos hayamos hecho.

Entonces, seguramente, habremos llegado a una nueva singularidad. Nuestro propio afán de avanzar científicamente nos llevará a lograrlo.

Este artículo fue publicado originalmente en The Conversation, un sitio de noticias sin fines de lucro dedicado a compartir ideas de expertos académicos.

Lee mas:

¿Puede “ver” una máquina? Visión por computador y sus aplicaciones

Humanos o robots: La innovación tecnológica como riesgo de pérdida de empleos

‘2001: Una odisea del espacio’: una huella imborrable 55 años después de su estreno

Aitor Moreno Fdz. de Leceta es Investigador Principal en Ibermática Fundazioa (Instituto Ibermática de Innovación).

Yahoo Noticias

Yahoo Noticias