Opinión: La degradación de mujeres y niñas en internet que observamos con indiferencia

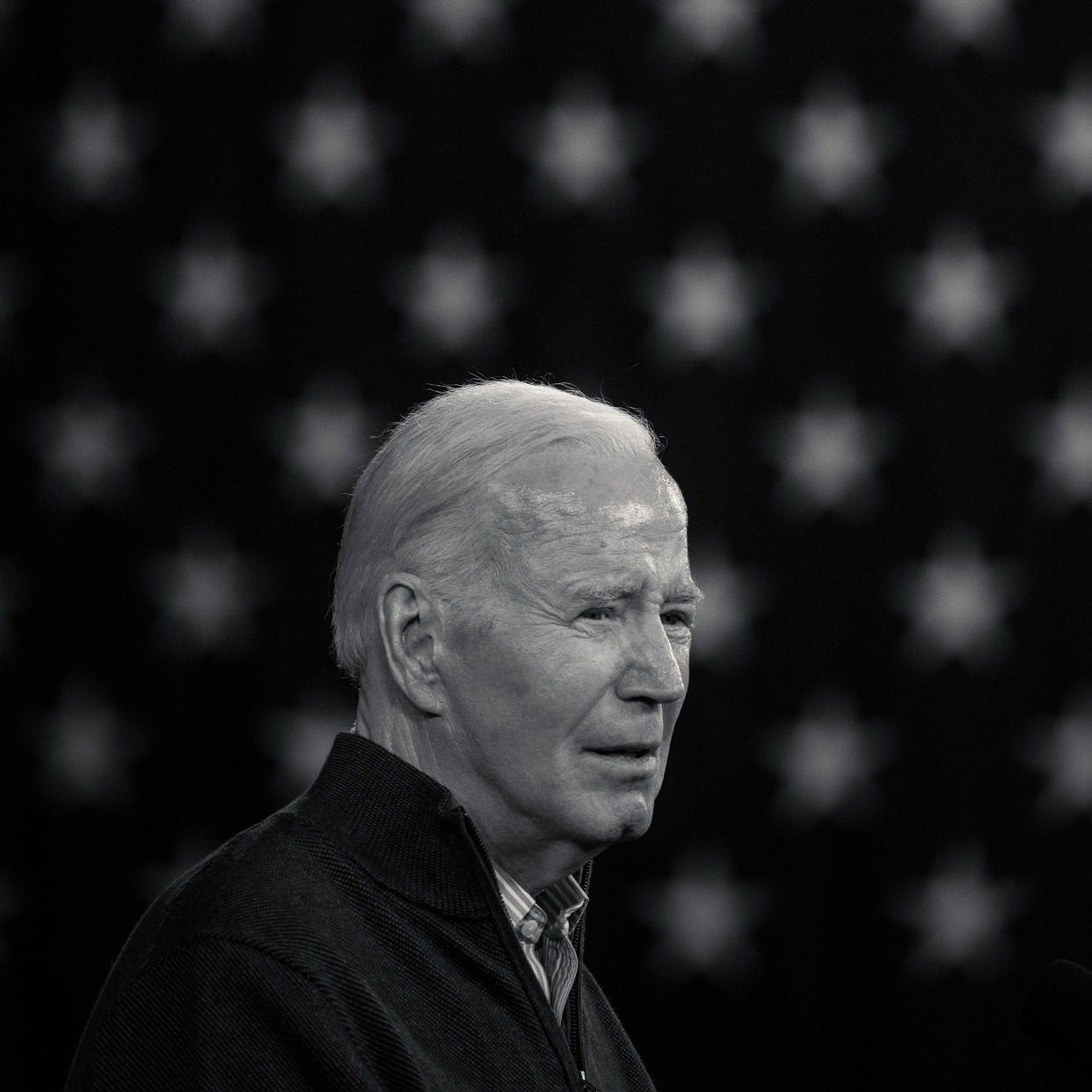

Suenan a todo volumen las alarmas sobre los ultrafalsos creados con inteligencia artificial que manipulan a los electores, como las robollamadas que suenan como el presidente Joe Biden que recibieron los hogares en New Hampshire, o el video falso en el que Taylor Swift apoya a Donald Trump.

Sin embargo, hay un problema mucho más grande con los ultrafalsos al que no le hemos puesto suficiente atención: los videos y fotografías ultrafalsos de desnudos que humillan a celebridades y a menores desconocidos por igual. Un estudio reciente halló que el 98 por ciento de los videos ultrafalsos en internet eran pornográficos y que el 99 por ciento de las víctimas eran mujeres o niñas.

Francesca Mani, una estudiante de 14 años que cursa el primer año de preparatoria, me dijo que estaba en clase en octubre cuando por el altavoz la llamaron a la oficina escolar. Ahí, el director suplente y un consejero le dijeron que uno o más compañeros de clase habían usado un programa de desnudos falsos para convertir una foto suya en la que estaba vestida y generar una imagen en la que aparecía sin ropa. Los chicos también habían creado imágenes de desnudos de otras compañeras de grado.

Esforzándose por no llorar, sintiéndose violada y humillada, Francesca regresó con dificultades a clase. En el pasillo, relató, pasó por donde estaba otro grupo de chicas que lloraban por la misma razón, y un montón de niños que se burlaban de ellas.

“Cuando vi que los chicos se reían, me enojé muchísimo”, aseguró Francesca. “Después de la escuela, llegué a casa, y le dije a mi mamá que debíamos hacer algo al respecto”.

Francesca, ahora de 15 años, creó un sitio web acerca del problema de los ultrafalsos —aiheeelp.com— y comenzó a reunirse con legisladores estatales y miembros del Congreso a manera de iniciativa para llamar la atención sobre el tema.

Aunque siempre ha habido imágenes modificadas, la IA hace que el proceso sea mucho más fácil. Con tan solo una buena imagen del rostro de una persona, ahora es posible en tan solo media hora crear un video sexual de 60 segundos de esa persona. Esos videos después pueden publicarse en sitios web pornográficos generales para que cualquiera pueda verlos, o también en sitios especializados de ultrafalsos.

Los videos son explícitos y a veces sádicos, y muestran, por ejemplo, a mujeres atadas mientras las violan o les orinan encima. Un sitio ofrece categorías como “violación” (472 videos), “llanto” (655) y “degradación” (822).

Además, están los sitios web y aplicaciones para “desnudar” o “desvestir” del tipo de la que Francesca fue víctima. “Desviste con un clic”, anuncia una de estas. Se usan de manera abrumadora para atacar a mujeres y niñas; algunas aplicaciones ni siquiera pueden generar la imagen de un varón desnudo. Un estudio británico sobre imágenes sexuales de menores producidas por AI reveló que el 99,6 por ciento eran de niñas, la mayoría de entre 7 y 13 años.

Graphika, una empresa de análisis en línea, identificó 34 sitios web usados para desnudar que recibieron un total de 24 millones de visitantes únicos tan solo en septiembre.

Cuando atacaron a Francesca, su familia consultó a la policía y abogados, pero no encontró remedio. “No hay nadie a quien recurrir”, señaló su madre, Dorota Mani. “La policía dice: ‘Lo sentimos, pero no podemos hacer nada’”.

El problema es que no hay una ley que se haya infringido como tal. “Seguimos sin tener un marco jurídico lo suficientemente ágil para abordar la tecnología”, afirmó Yiota Souras, directora jurídica del Centro Nacional para Menores Desaparecidos y Explotados.

Sophie Compton, directora de documentales, hizo una película sobre el tema, “Another Body”, y quedó tan consternada que puso en marcha una campaña y un sitio web, MyImageMyChoice.org, para impulsar el cambio.

“Se ha convertido en una especie de industria demente, completamente basada en la violación del consentimiento”, acusó Compton.

La impunidad refleja una actitud indiferente ante la humillación de las víctimas. Una encuesta reveló que el 74 por ciento de los usuarios de ultrafalsos pornográficos afirmaban no sentirse culpables por ver los videos.

En la actualidad existe un consenso al que se llegó con uñas y dientes sobre lo inaceptables que son los besos no deseados, los manoseos y los comentarios denigrantes. Entonces, ¿cómo es que permitimos este otro tipo de violación? ¿Cómo puede importarnos tan poco proteger a las mujeres y las niñas de la degradación en internet?

“La mayoría de las sobrevivientes con las que hablo dicen que han contemplado el suicidio”, señaló Andrea Powell, que trabaja con personas que han sido víctimas de ultrafalsos y desarrolla estrategias para abordar el problema.

Se trata de una carga que recae de manera desproporcionada sobre mujeres prominentes. Un sitio web de ultrafalsos muestra el retrato oficial de una diputada del Congreso y, a continuación, 28 videos sexuales falsos de ella. Otro sitio web tiene 90. (No proporciono los enlaces a esos sitios porque, a diferencia de Google, no estoy dispuesto a dirigir tráfico a esos sitios y permitirles que se sigan lucrando con imágenes no consentidas).

Es menos común que las víctimas de los ultrafalsos sean varones, quienes a menudo son atacados con fines de “sextorsión” o extorsión sexual, es decir, cuando un depredador amenaza con difundir imágenes vergonzosas a menos que la víctima pague dinero o proporcione desnudos. El año pasado, el FBI advirtió de un aumento de los ultrafalsos utilizados con fines de “sextorsión”, que a veces han sido un factor en los suicidios de niños.

“Las imágenes parecen tan reales que asustan e incluso hay un video mío en el que aparezco haciendo cosas repugnantes y también luce aterradoramente real”, denunció un chico de 14 años al Centro Nacional para Menores Desaparecidos y Explotados. Ese niño envió los datos de su tarjeta de débito a un depredador que amenazó con publicar los ultrafalsos en internet.

Según entiendo, Google y otros motores de búsqueda están dirigiendo tráfico de manera imprudente a sitios porno con ultrafalsos no consentidos. Google es esencial para el modelo de negocio de estas empresas maliciosas.

En una búsqueda que hice en Google, siete de los diez primeros resultados eran videos de sexo explícito en los que aparecían mujeres famosas. Utilizando los mismos términos de búsqueda en el motor de búsqueda Bing de Microsoft, había diez videos. Pero esto no es inevitable: En Yahoo, no se arrojó como resultado ningún video.

En otros ámbitos, Google hace lo correcto. Si se pregunta: “¿Cómo me suicido?”, el motor no ofrece una guía paso a paso; en su lugar, el primer resultado es una línea de prevención para el suicidio. Si se pregunta: “¿Cómo enveneno a mi cónyuge?”, el sitio no será de mucha ayuda. En otras palabras, Google es socialmente responsable cuando quiere, pero parece indiferente a las mujeres y niñas violadas por los pornógrafos.

“Google tiene que asumir su responsabilidad por permitir este tipo de problemas”, afirmó Breeze Liu, víctima de pornografía vengativa y ultrafalsos. “Tiene el poder de detener esto”.

Liu quedó destrozada cuando en 2020 recibió un mensaje de un amigo para que lo dejara todo y lo llamara de inmediato.

“No quiero que entres en pánico, pero hay un video tuyo en Pornhub”, le dijo cuando lo llamó.

Resultó ser un video de desnudos que había sido grabado sin que Liu lo supiera. Pronto lo descargaron y lo subieron en muchas otras páginas porno, y al parecer luego se utilizó para crear videos ultrafalsos en los que aparecía realizando actos sexuales. En total, el material apareció en al menos 832 enlaces.

Liu estaba mortificada. No sabía cómo decírselo a sus padres. Subió a lo alto de un edificio y se preparó para saltar.

Al final, Liu no saltó. Al igual que Francesca, se sintió furiosa y decidió ayudar a otras personas en su misma situación.

“Nos humillan por vivir nuestra sexualidad y los perpetradores resultan indemnes”, comentó. “Eso no tiene sentido”.

Liu, que había trabajado para una empresa de capital riesgo en tecnología, fundó una empresa emergente, Alecto AI, cuyo objetivo es ayudar a las víctimas de pornografía no consentida a localizar imágenes suyas y lograr que se eliminen. Una versión piloto de la aplicación Alecto ya está disponible sin costo para dispositivos Apple y Android, y Liu espera colaborar con empresas tecnológicas para ayudar a eliminar el contenido no consentido.

La tecnología puede resolver los problemas que provocó la tecnología, dijo.

Google está de acuerdo en que hay oportunidad para mejorar. Ningún responsable de Google quiso hablar conmigo del problema, pero Cathy Edwards, vicepresidenta de búsquedas de la compañía, emitió un comunicado en el que señaló: “Entendemos lo angustioso que puede ser este contenido y nos comprometemos a mejorar nuestras protecciones existentes para ayudar a las personas afectadas”.

“Estamos desarrollando salvaguardas adicionales en Google Search”, añadió el comunicado, en el que recalcó que la compañía ha establecido un proceso en el que las víctimas de ultrafalsos pueden solicitar la eliminación de esos enlaces en los resultados de búsqueda.

Una portavoz de Microsoft, Caitlin Roulston, ofreció una declaración similar, señalando que la compañía tiene un formulario web que permite a las personas solicitar la eliminación de un enlace a imágenes suyas de desnudos en los resultados de búsqueda de Bing. El comunicado animaba a los usuarios a ajustar la configuración de búsqueda segura para “bloquear contenidos para adultos no deseados” y reconocía que “el trabajo debía continuar”.

No me impresiona. No veo por qué Google y Bing deberían dirigir tráfico a sitios web de ultrafalsos cuyo negocio son las imágenes no consentidas de sexo y desnudos. Los motores de búsqueda son pilares de ese ecosistema sórdido y explotador. Pueden mejorar, Google y Bing.

Las empresas de IA no son tan culpables como Google, pero no han sido tan cuidadosas como podrían. Rebecca Portnoff, vicepresidenta de ciencia de datos de Thorn, una organización sin ánimo de lucro que crea tecnología para combatir los abusos sexuales a menores, señala que los modelos de IA se entrenan utilizando imágenes de internet, pero se pueden desviar de los sitios web que incluyen abusos sexuales a menores. El resultado: no pueden generar tan fácilmente lo que no conocen.

El año pasado, Biden firmó una prometedora orden ejecutiva para tratar de introducir salvaguardas en la IA, incluyendo los ultrafalsos, y se han presentado varios proyectos de ley en el Congreso. Algunos estados han promulgado sus propias medidas.

Estoy a favor de que se tomen medidas penales contra los ultrafalsos, pero es fácil aprobar una ley y difícil hacerla cumplir. Una herramienta más eficaz podría ser más sencilla: la responsabilidad civil por los daños que causen estos ultrafalsos. En la actualidad, las empresas tecnológicas están en gran medida exentas de responsabilidad en virtud de la Sección 230 de la Ley de Decencia en las Comunicaciones, pero si esa ley se modifica y las empresas supieran que se enfrentan a demandas y pagos por daños y perjuicios, sus incentivos cambiarían y establecerían mecanismos de vigilancia. Así, se vendría abajo el modelo de negocio de algunas empresas de ultrafalsos.

Michael Bennet, senador demócrata por Colorado, y otros han propuesto un nuevo organismo regulador federal para supervisar a las empresas tecnológicas y los nuevos medios, igual que la Comisión Federal de Comunicaciones supervisa los medios antiguos. Eso me parece lógico.

He llegado a la conclusión de que los mayores obstáculos a la regulación de los ultrafalsos no son técnicos o jurídicos —aunque esos existen—, sino simplemente nuestra complacencia colectiva.

La sociedad también fue alguna vez complaciente con la violencia doméstica y el acoso sexual. En las últimas décadas, hemos sentido más empatía por las víctimas y hemos creado sistemas de rendición de cuentas que, aunque imperfectos, han fomentado una sociedad más civilizada.

Ha llegado la hora de ser igual de responsables en el espacio digital. Se crean nuevas tecnologías, desde luego, pero no tenemos por qué doblegarnos ante ellas. Me asombra que la sociedad al parecer crea que las mujeres y las niñas deben aceptar el tormento que causan las imágenes degradantes. En lugar de eso, deberíamos apoyar a las víctimas y tomar medidas enérgicas contra los ultrafalsos que permiten a las empresas lucrarse con la degradación sexual, la humillación y la misoginia.

—

Si tienes pensamientos suicidas, llama o envía un mensaje de texto al 988 para ponerte en contacto con la Línea Nacional de Prevención del Suicidio o visita SpeakingOfSuicide.com/resources para obtener una lista de recursos adicionales.

—

Contacta a Kristof en Facebook.com/Kristof, Twitter.com/NickKristof o por correo en The New York Times, 620 Eighth Ave., Nueva York, NY 10018.

c.2024 The New York Times Company

Yahoo Noticias

Yahoo Noticias