La actividad más amenazante en internet no es la que tú crees | OPINIÓN

Este año, Facebook y Twitter permitieron que se distribuyera en sus plataformas el video de una charla en la que Michael J. Knowles, un experto de derecha, pedía que se “erradicara la transgeneridad”. La Conferencia de Acción Política Conservadora (CPAC, por su sigla en inglés), que organizó la charla, señaló en sus publicaciones de redes sociales con las que promocionó el video que la charla trataba “sobre el intento de la izquierda de borrar a las mujeres biológicas de la sociedad moderna”.

Nada de esto fue censurado por las plataformas tecnológicas porque ni Knowles ni la CPAC infringieron las normas de incitación al odio de las plataformas que prohíben ataques directos contra las personas por ser quienes son. Sin embargo, al permitir que se difundiera ese discurso en sus plataformas, las empresas de redes sociales hicieron algo que quizá debería preocuparnos aún más: fomentaron el miedo a un grupo marginado.

Casi todas las plataformas tecnológicas elaboraron normas exhaustivas y detalladas para prohibir el discurso de odio tras comprobar que lo primero que ocurre en una nueva red social es que los usuarios empiezan a lanzarse insultos. La Unión Europea incluso monitorea la rapidez con que las plataformas tecnológicas eliminan el discurso de odio.

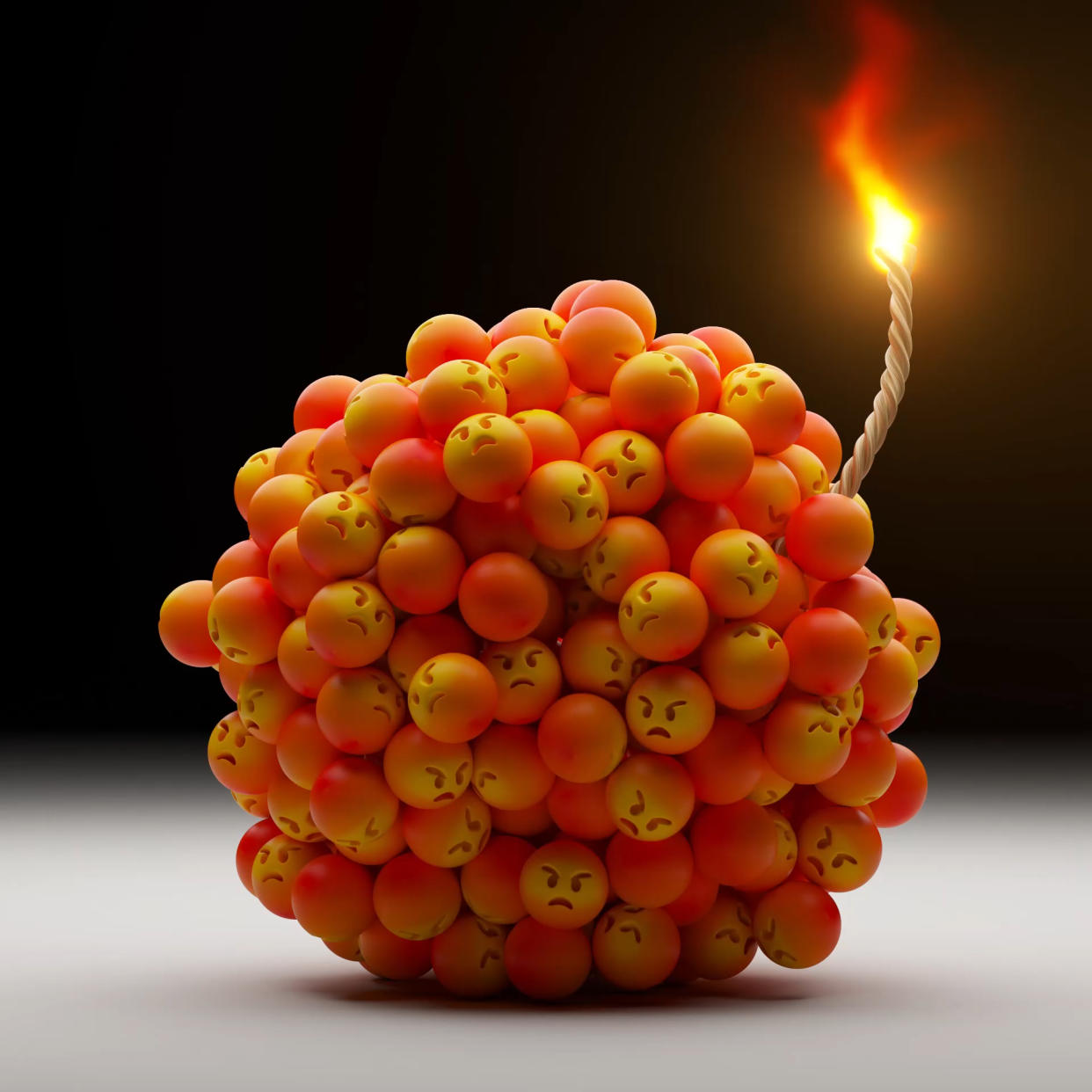

No obstante, los líderes usan el miedo como un arma, aún más que el odio, cuando buscan desatar violencia. El odio a menudo es parte de la ecuación, por supuesto, pero el miedo es casi siempre el ingrediente clave cuando la gente siente que debe arremeter para defenderse.

También te puede interesar:

Algo a lo que debereía prestarse mucha atención

Comprender la diferencia entre el discurso que induce al miedo y el que incita al odio es crucial a la hora de decidir de manera colectiva cómo gobernar las plataformas globales de internet. La mayoría de las plataformas tecnológicas no eliminan afirmaciones falsas que incitan al miedo, como: “Antifa viene a invadir tu ciudad” o “Tus enemigos políticos son pedófilos que van tras tus hijos”. Pero al permitir que se difundan mentiras como estas, las plataformas están permitiendo que los tipos de discurso más peligrosos impregnen nuestra sociedad.

Susan Benesch, directora ejecutiva del Dangerous Speech Project, dice que los líderes genocidas suelen utilizar el miedo a una amenaza inminente para incitar a los grupos a la violencia preventiva. Quienes cometen violencia no necesitan odiar a las personas a las que atacan. Solo necesitan tener miedo de las consecuencias de no atacar.

Por ejemplo, antes del genocidio ruandés de 1994, los políticos hutus aseguraron a los demás miembros de esa etnia que estaban a punto de ser exterminados por los tutsis. Durante el Holocausto, los propagandistas nazis declararon que los judíos planeaban aniquilar al pueblo alemán. Antes del genocidio bosnio, se advirtió a los serbios que se protegieran de una amenaza musulmana fundamentalista que planeaba un genocidio contra ellos.

“Me sorprendió lo parecida que es esta retórica de un caso a otro”, me dijo Benesch en una entrevista para The Markup. “Es como si hubiera una escuela horrible a la que todos asisten”. La característica clave del discurso peligroso, argumentó, es que persuade “a la gente para que perciba a otros miembros de un grupo como una terrible amenaza. Eso hace que la violencia parezca aceptable, necesaria o incluso virtuosa”.

Un gran desconocido

El discurso de miedo está mucho menos estudiado que el discurso de odio. En 2021, un equipo de investigadores del Instituto Indio de Tecnología y el Instituto Tecnológico de Massachusetts publicó el primer estudio cuantitativo a gran escala sobre el discurso de miedo.

En un análisis de dos millones de mensajes de WhatsApp en grupos de chat públicos de la India, descubrieron que el discurso de miedo era notablemente difícil de detectar para los sistemas automatizados porque no siempre contiene las palabras despectivas que pueden caracterizar al discurso de odio.

“Observamos que muchos de ellos se basan en información objetivamente inexacta destinada a engañar al lector”, escribieron los autores del artículo, Punyajoy Saha, Binny Mathew, Kiran Garimella y Animesh Mukherjee. (Garimella se trasladó del MIT a la Universidad Rutgers tras la publicación del artículo).

A menudo es necesario el juicio humano para diferenciar entre los miedos reales y los falsos, pero las plataformas tecnológicas no suelen dedicar tiempo ni desarrollar los conocimientos locales necesarios para investigar todos los miedos que se expresan.

Tres de los autores y un nuevo colaborador, Narla Komal Kalyan, realizaron este año una comparación entre el discurso de miedo y el de odio en la red social de derecha Gab. La “naturaleza no tóxica y argumentativa” del discurso de miedo suscita más participación que el discurso de odio, según descubrieron.

Cómo protegernos ante el discurso del miedo

Entonces, ¿cómo nos vacunamos contra el discurso de miedo que puede incitar a la violencia en las redes sociales? Los primeros pasos son identificarlo y reconocerlo como la táctica cínica que es. Las plataformas tecnológicas deberían invertir en más personas que puedan comprobar los hechos, y añadir contexto y contrapuntos a los mensajes falsos que inducen al miedo.

Otro planteamiento es que las plataformas de redes sociales dejen de depender de los llamados algoritmos de interacción, diseñados para mantener a la gente en el sitio el mayor tiempo posible, y que también acaban amplificando el contenido indignante y divisivo. La Unión Europea ya está tomando medidas de ese estilo al exigir a las grandes plataformas de internet que ofrezcan a los usuarios al menos un algoritmo alternativo.

Ravi Iyer, que trabajó en el mismo equipo que Frances Haugen, la denunciante de Facebook, ahora es director general del Psychology of Technology Institute. Este instituto, que forma parte del Centro Neely de la Escuela de Negocios Marshall de la Universidad del Sur de California, estudia cómo puede utilizarse la tecnología en beneficio de la salud mental. En un artículo preliminar publicado el mes pasado, él, Jonathan Stray y Helena Puig Larrauri sugirieron que las plataformas pueden reducir el conflicto destructivo restando importancia a algunas métricas que promueven la participación.

Eso podría significar que, para ciertos temas candentes, las plataformas no potenciarían de manera automática las publicaciones que obtuvieran buenos resultados en las métricas típicas de participación, como el número de comentarios, número de veces compartidas y tiempo dedicado a cada publicación. Al fin y al cabo, esas métricas no significan necesariamente que al usuario le haya gustado la publicación. Los usuarios podrían estar interactuando con el contenido porque les parece censurable o simplemente les llama la atención.

En su lugar, los investigadores proponen que los algoritmos de las redes sociales potencien las publicaciones que los usuarios indiquen explícitamente que les parecen valiosas.

Facebook ha estado aplicando discretamente este enfoque a los contenidos políticos. En abril la compañía señaló que “sigue alejándose de la clasificación de contenido basada en la participación” y, en su lugar, da más importancia a que los usuarios “aprendan lo que es informativo, merece su tiempo o es significativo”.

El cambio de Facebook podría ser la razón de que la charla de Knowles tuviera muchas menos visitas en Facebook que en Twitter, que no ha adoptado este cambio algorítmico.

Pero, al final, los algoritmos no van a salvarnos. Pueden degradar el discurso de miedo, pero no borrarlo. Nosotros, los usuarios de las plataformas, también tenemos un papel que desempeñar en la lucha contra el alarmismo a través del contradiscurso, en el que líderes y espectadores responden negativamente a la incitación al miedo. El objetivo del contradiscurso no es necesariamente cambiar las opiniones de los verdaderos creyentes, sino más bien proporcionar una contranarrativa para las personas que observan desde fuera.

El humor puede ser una buena defensa: en Kenia, en 2012, un popular programa de televisión, “Vioja Mahakamani”, probó una estrategia de inoculación haciendo que sus personajes se burlaran de los esfuerzos de los líderes comunitarios por estereotipar a distintos grupos. Los telespectadores encuestados en grupos de debate se mostraron más escépticos ante los políticos que atizan el miedo para fomentar la violencia.

Combatir el miedo no será fácil. Pero quizá sea el trabajo más importante que podamos hacer para evitar que la indignación en internet genere violencia en la vida real.

Este artículo apareció originalmente en The New York Times.

También te puede interesar | EN VIDEO: Mi activismo en las redes sociales: Los juguetes de la esperanza

c.2023 The New York Times Company

Yahoo Noticias

Yahoo Noticias