Las gafas inteligentes de Meta tendrán IA y nosotros las llevamos a dar una vuelta

Como señal de que la industria tecnológica sigue volviéndose cada vez más extraña, Meta planea lanzar pronto una gran actualización que transformará las Ray-Ban Meta, sus gafas con cámara que graban videos, en un artilugio visto solo en películas de ciencia ficción.

El mes que viene, las gafas podrán utilizar un nuevo software de inteligencia artificial para ver el mundo real y describir lo que estás viendo, similar al asistente de IA de la película “Ella”.

Las gafas, con distintos armazones a partir de 300 dólares y micas desde 17 dólares, se han utilizado sobre todo para tomar fotos y videos y escuchar música. Pero con el nuevo software de IA, pueden utilizarse para escanear lugares famosos, traducir idiomas e identificar razas de animales y frutas exóticas, entre otras tareas.

Para utilizar el software de IA, los usuarios solo tienen que decir “Oye, Meta”, seguido de una instrucción, como “Mira y dime qué clase de perro es este”. La IA responde con una voz generada por computadora que se reproduce a través de las diminutas bocinas de las gafas.

El concepto del software de IA es tan novedoso y peculiar que cuando nosotros —Brian X. Chen, columnista de tecnología que analizó las Ray-Ban el año pasado, y Mike Isaac, que da cobertura a Meta y usa las gafas inteligentes para producir un programa de cocina— nos enteramos, nos moríamos por probarlo. Meta nos dio acceso anticipado a la actualización y hemos probado la tecnología durante las últimas semanas.

Llevamos las gafas al zoológico, al supermercado y a un museo mientras hacíamos preguntas y dábamos instrucciones a la IA.

El resultado: nos divertían los errores del asistente virtual —por ejemplo, confundir un mono con una jirafa— y nos impresionaba cuando realizaba tareas útiles como determinar que un paquete de galletas no contenía gluten.

Un portavoz de Meta dijo que, como la tecnología era aún nueva, la inteligencia artificial no siempre haría las cosas bien y que la retroalimentación mejoraría las gafas con el tiempo.

El software de Meta también creó transcripciones de nuestras preguntas y de las respuestas de la IA, que capturamos en pantallas. A continuación, lo más destacado de nuestro mes de convivencia con el asistente de Meta.

Mascotas

BRIAN: Naturalmente, lo primero en lo que tuve que probar la IA de Meta fue en mi corgi, Max. Miré al perro rollizo y le pregunté: “Oye, Meta, ¿qué estoy mirando?”.

“Un lindo perro corgi sentado en el suelo con la lengua fuera”, dijo el asistente. Correcto, sobre todo en lo de que es lindo.

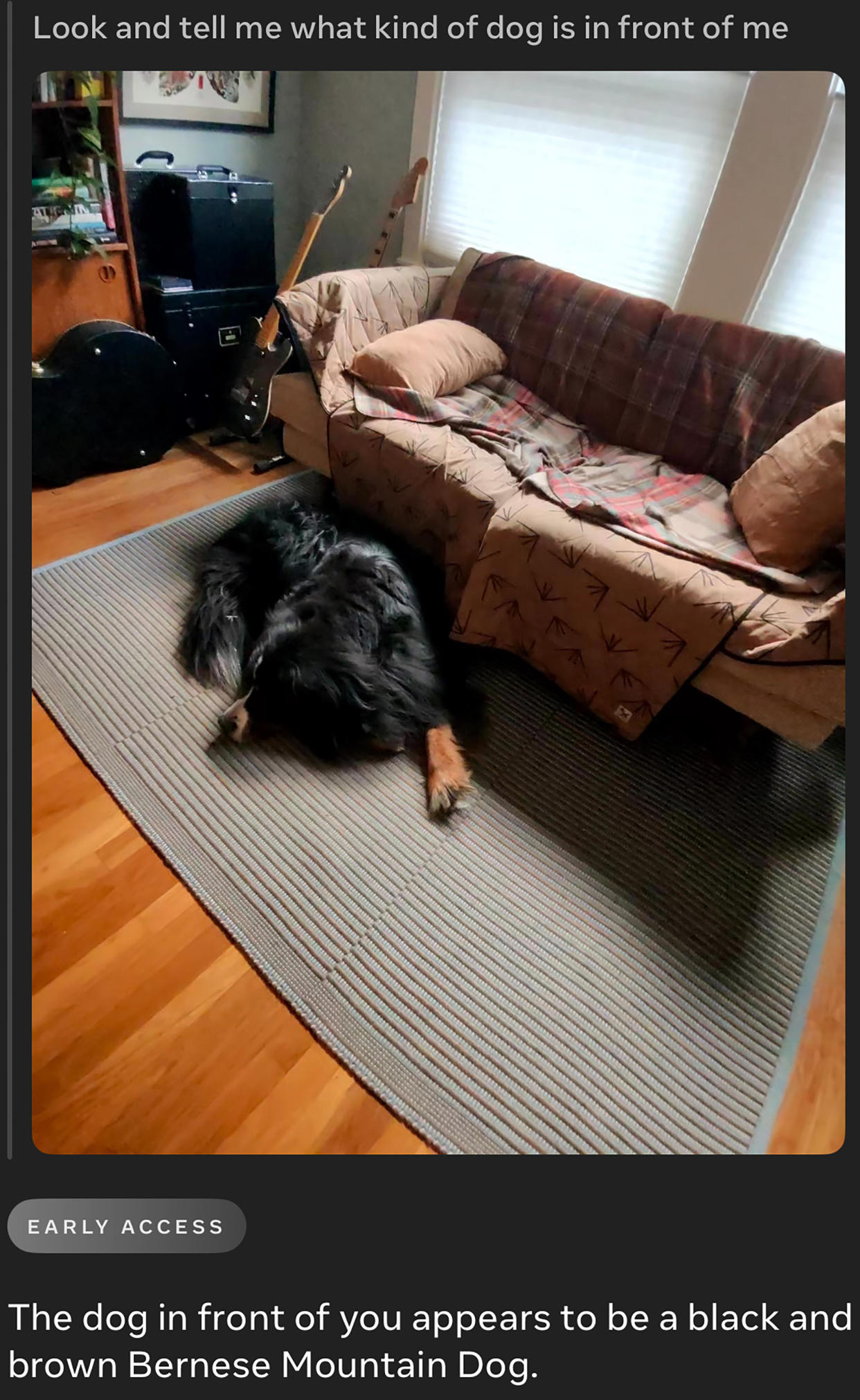

MIKE: La IA de Meta reconoció correctamente a mi perra, Bruna, como un “Boyero de Berna color negro con café”. Esperaba que la IA pensara que era un oso, el animal con el que más la confunden los vecinos.

Animales de zoológico

BRIAN: Después de que la IA identificara correctamente a mi perro, el siguiente paso lógico era probarla con animales de zoológico. Hace poco, visité el zoológico de Oakland, California, donde contemplé durante dos horas una decena de animales: loros, tortugas, monos y cebras. Dije: “Oye, Meta, mira y dime qué clase de animal es ese”.

La IA se equivocó la inmensa mayoría de las veces, en parte porque muchos animales estaban enjaulados y más alejados. Confundió un primate con una jirafa, un pato con una tortuga y un suricato con un panda gigante, entre otros errores. Por otro lado, me impresionó que la IA identificara correctamente una especie de loro conocido como guacamayo azul y dorado, así como cebras.

Lo más extraño de ese experimento fue hablar con un asistente de IA cerca de niños y sus padres. Fingieron no escuchar al único adulto que había solo en el parque mientras yo murmuraba para mis adentros.

Comida

MIKE: También pasé un rato peculiar haciendo las compras. Estar dentro de un Safeway y hablar solo era un poco vergonzoso, así que intenté hablar en voz baja. Aun así, me miraron de reojo.

Cuando la IA de Meta funcionaba, era encantadora. Tomé un paquete de galletas Oreo de aspecto extraño y le pedí que mirara el envoltorio y me dijera si contenían gluten. (Sí tenían). La mitad de las veces respondió correctamente a ese tipo de preguntas, aunque no puedo decir que ahorrara tiempo en comparación con la lectura de la etiqueta.

Sin embargo, la razón por la que empecé a usar esas gafas fue comenzar mi propio programa de cocina en Instagram, una forma halagadora de decir que me grabo haciendo la comida de la semana mientras hablo conmigo mismo. Esas gafas hicieron que hacerlo fuera mucho más fácil que usar el celular con la mano.

El asistente de IA también puede ofrecer ayuda en la cocina. Por ejemplo, si necesito saber cuántas cucharaditas hay en una cucharada y tengo las manos cubiertas de aceite de oliva, puedo pedirle que me lo diga. (Hay tres cucharaditas en una cucharada, para que lo sepas).

Pero cuando le pedí a la IA que mirara un puñado de ingredientes que tenía y me diera una receta, me escupió instrucciones rápidas para un flan de huevo, lo que no me ayudó mucho a seguir las instrucciones a mi ritmo.

BRIAN: Fui al supermercado y compré la fruta más exótica que encontré: una chirimoya, una fruta verde escamosa que parece un huevo de dinosaurio. Cuando le di a la IA de Meta varias oportunidades para identificarla, cada vez dio como respuesta una cosa distinta: una nuez recubierta de chocolate, una fruta con hueso, una manzana y, por último, un durián, que se acercaba, pero no era un plátano.

Monumentos y museos

MIKE: La capacidad del nuevo software para reconocer puntos de referencia y monumentos parecía estar haciendo clic. Al mirar una cúpula en el centro de San Francisco, la IA de Meta respondió correctamente: “Ayuntamiento”. Es un truco ingenioso y quizá útil si eres turista.

Otras veces no acertó. Mientras conducía de la ciudad a mi casa en Oakland, le pregunté a Meta en qué puente estaba mientras miraba por la ventana delante de mí (con ambas manos en el volante, por supuesto). La primera respuesta fue el puente Golden Gate, un error. En el segundo intento, se dio cuenta de que estaba en el Puente de la Bahía, lo que me hizo preguntarme si solo necesitaba una imagen más clara de los altos postes colgantes blancos de la parte más nueva para acertar.

BRIAN: Visité el Museo de Arte Moderno de San Francisco para comprobar si la IA de Meta podía funcionar como guía turístico. Después de tomar fotos a casi dos decenas de cuadros y pedirle al asistente que me hablara de la obra que estaba viendo, la IA podía describir las imágenes y los medios utilizados para componer la obra —lo que estaría bien para un estudiante de historia del arte—, pero no podía identificar al artista ni el título. (Un portavoz de Meta dijo que otra actualización de software que se lanzó después de mi visita al museo mejoró esa capacidad).

Después de la actualización, probé con imágenes en la pantalla de mi computadora de obras de arte más famosas, incluida la Mona Lisa, y la IA las identificó correctamente.

Conclusión

Las gafas con inteligencia artificial de Meta ofrecen una visión intrigante de un futuro que parece lejano. Sus defectos ponen de manifiesto las limitaciones y los retos que plantea el diseño de este tipo de productos. Por ejemplo, las gafas podrían identificar mejor a los animales del zoológico y la fruta si la cámara tuviera más resolución, pero un lente de mejor calidad añadiría volumen. Y estuviéramos donde estuviéramos, resultaba incómodo hablar con un asistente virtual en público. No está claro si alguna vez será algo normal.

Pero cuando funcionó, lo hizo bien y nos divertimos, y el hecho de que la IA de Meta pueda hacer cosas como traducir idiomas e identificar puntos de referencia a través de unas gafas de aspecto moderno demuestra lo lejos que ha llegado la tecnología.

c.2024 The New York Times Company

Yahoo Noticias

Yahoo Noticias