La inteligencia artificial cada vez lee mejor la mente

Piensa en las palabras que te rondan por la cabeza: ese chiste de mal gusto que sabiamente te guardaste para ti en la cena; tu impresión no expresada de la nueva pareja de tu mejor amigo. Ahora imagina que alguien pudiera escucharlas.

El lunes, científicos de la Universidad de Texas, en Austin, dieron un paso más en esa dirección. En un estudio publicado en la revista Nature Neuroscience, los investigadores describen una inteligencia artificial capaz de traducir los pensamientos privados de humanos por medio de análisis de imágenes de resonancia magnética funcional (IRMf), que miden el flujo de sangre a distintas regiones del cerebro.

Los investigadores ya han desarrollado métodos de descodificación del lenguaje para captar los intentos de habla de personas que han perdido la capacidad de hablar y permitir que personas paralíticas escriban con solo pensar en escribir. Pero el nuevo descodificador es uno de los primeros que no depende de implantes. En el estudio, fue capaz de convertir el habla imaginaria de una persona en habla real y, cuando a los sujetos se les proyectaban películas mudas, podía generar descripciones relativamente precisas de lo que ocurría en la pantalla.

“No se trata solo de un estímulo lingüístico”, explicó Alexander Huth, neurocientífico de la universidad que dirigió la investigación. “Estamos llegando al significado, a algo sobre la idea de lo que está ocurriendo. Y el hecho de que eso sea posible es muy emocionante”.

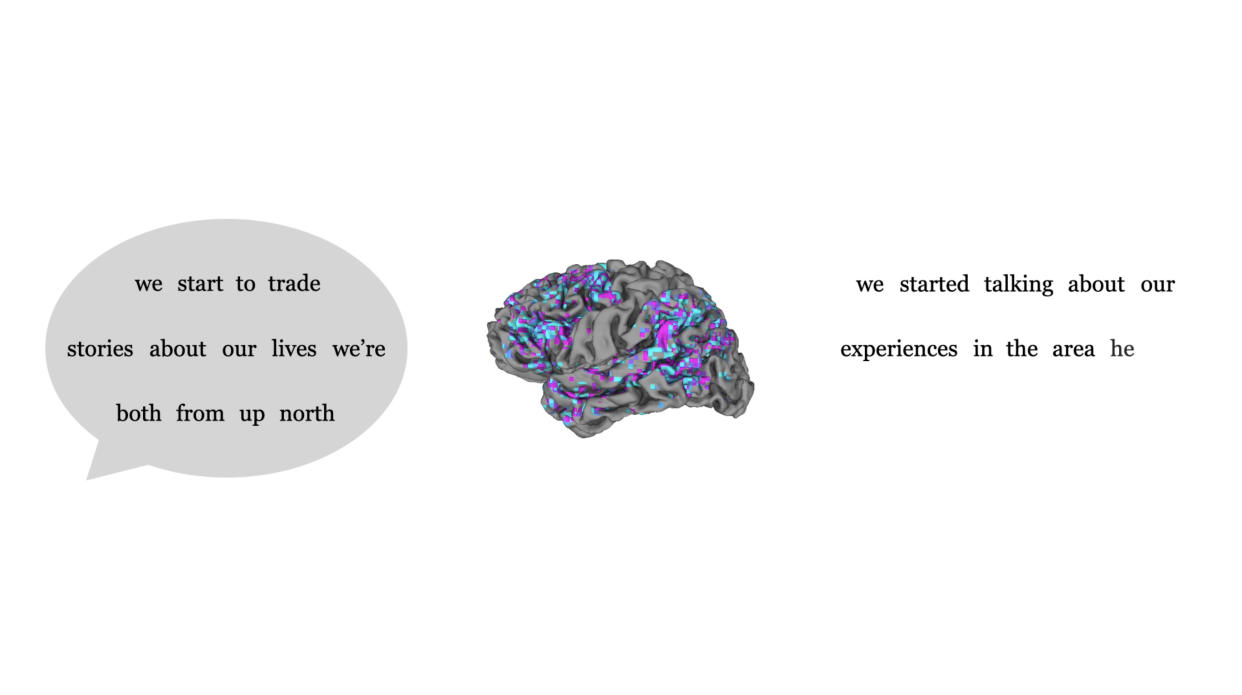

El estudio se concentró en tres participantes, que acudieron al laboratorio de Huth durante dieciséis horas a lo largo de varios días para escuchar “The Moth” y otros pódcast narrativos. Mientras escuchaban, un escáner de IRMf registraba los niveles de oxigenación sanguínea en partes de sus cerebros. A continuación, los investigadores utilizaron un gran modelo lingüístico para relacionar los patrones de actividad cerebral con las palabras y frases que habían escuchado los participantes.

Los grandes modelos lingüísticos, como GPT-4 de OpenAI y Bard de Google, se entrenan con grandes cantidades de textos escritos para predecir la siguiente palabra de una frase u oración. En el proceso, los modelos crean mapas que indican cómo se relacionan las palabras entre sí. Hace años, Huth se dio cuenta de que algunas partes de estos mapas —las llamadas incrustaciones de contexto, que captan las características semánticas o significados de las frases— podían utilizarse para predecir cómo se ilumina el cerebro en respuesta al lenguaje.

En un sentido básico, afirmó Shinji Nishimoto, neurocientífico de la Universidad de Osaka que no participó en la investigación, “la actividad cerebral es una especie de señal encriptada, y los modelos lingüísticos proporcionan formas de descifrarla”.

En su estudio, Huth y sus colegas invirtieron el proceso en la práctica, pues utilizaron otra IA para traducir las imágenes IRMf del participante en palabras y frases. Los investigadores probaron el descodificador haciendo que los participantes escucharan nuevas grabaciones y comprobando después hasta qué punto la traducción se correspondía con la transcripción real.

Casi todas las palabras estaban fuera de lugar en el guion descodificado, pero el significado del pasaje por lo general se conservaba. En esencia, los descodificadores parafraseaban.

Transcripción original

:

“Me levanté del colchón inflable y apreté mi cara contra el cristal de la ventana de la habitación esperando ver unos ojos que me devolvieran la mirada, pero en su lugar solo encontré oscuridad”.

Descodificado a partir de la actividad cerebral:

“Seguí caminando hasta la ventana y abrí el cristal, me puse de puntitas y me asomé, no vi nada, volví a mirar hacia arriba y no vi nada”.

Mientras estaban bajo el escáner de IRMf, también se les pidió a los participantes que imaginaran en silencio que contaban una historia; después, repitieron la historia en voz alta, como referencia. También en este caso, el modelo de descodificación captó lo esencial de la versión tácita.

La versión del participante

:

“Buscar un mensaje de mi mujer diciendo que había cambiado de opinión y que volvería”.

Versión descodificada

:

“Al verla, por alguna razón pensé que vendría a mí y me diría que me echa de menos”.

Por último, los sujetos vieron una breve película de animación muda, de nuevo mientras se sometían a un escáner de IRMf. Al analizar su actividad cerebral, el modelo lingüístico pudo descodificar una sinopsis aproximada de lo que estaban viendo, quizá su descripción interna de lo que estaban viendo.

El resultado sugiere que el descodificador de IA no solo captaba palabras, sino también significados. “La percepción del lenguaje es un proceso externo, mientras que la imaginación es un proceso interno activo”, señaló Nishimoto. “Y los autores demostraron que el cerebro utiliza representaciones comunes en estos procesos”.

Greta Tuckute, neurocientífica del Instituto Tecnológico de Massachusetts que no participó en la investigación, dijo que esa era “la pregunta de alto nivel”.

“¿Podemos descodificar el significado a partir del cerebro?”, continuó. “En cierto modo, ellos demuestran que sí podemos”.

Este método de descodificación del lenguaje tenía limitaciones, señalaron Huth y sus colegas. Por un lado, los escáneres de IRMf son voluminosos y caros. Además, entrenar el modelo es un proceso largo y tedioso, y para que sea eficaz debe hacerse con individuos. Cuando los investigadores intentaron utilizar un descodificador entrenado a partir de una persona para leer la actividad cerebral de otra, falló, lo que sugiere que cada cerebro tiene formas únicas de representar el significado.

Los participantes también fueron capaces de blindar sus monólogos internos, pues despistaron al descodificador pensando en otras cosas. La IA quizá pueda leer nuestras mentes, pero por ahora tendrá que hacerlo una por una y con nuestro permiso.

c.2023 The New York Times Company

Yahoo Noticias

Yahoo Noticias