Háganse a un lado, matemáticos, que aquí viene AlphaProof

En las oficinas centrales de Google DeepMind, un laboratorio de inteligencia artificial en Londres, los investigadores establecieron desde hace mucho un ritual para el anuncio de resultados trascendentales: hacen sonar un enorme gong ceremonial.

En 2016, hicieron retumbar el gong para anunciar que el sistema de IA AlphaGo había logrado un desempeño sobresaliente en el juego Go. En 2017, el gong resonó cuando AlphaZero conquistó el ajedrez. En todas esas ocasiones, el algoritmo venció a campeones mundiales humanos.

La semana pasada, los investigadores de DeepMind sacaron de nuevo el gong para celebrar lo que Alex Davies, líder de la iniciativa matemática de Google DeepMind, describió como un “enorme logro” para un sistema de IA en el razonamiento matemático. Un par de modelos de Google DeepMind probaron suerte con los problemas planteados en la Olimpiada Internacional de Matemáticas de 2024 (IMO, por su sigla en inglés), celebrada del 11 al 22 de julio unos 160 kilómetros al oeste de Londres, en la Universidad de Bath. Este evento se considera la principal competencia de matemáticas para los “atletas matemáticos más brillantes” del mundo, según una publicación promocional en las redes sociales.

Los humanos que resolvieron los problemas (609 estudiantes de preparatoria de 108 países) ganaron 58 medallas de oro, 123 de plata y 145 de bronce. La IA tuvo un desempeño comparable al de un medallista de plata: resolvió cuatro de los seis problemas y obtuvo 28 puntos en total. Es la primera vez que una IA tiene un desempeño merecedor de una medalla en los problemas de una olimpiada.

“No fue perfecto, no resolvimos todo”, reconoció en una entrevista Pushmeet Kohli, vicepresidente de investigación de Google DeepMind. “Queremos que sea perfecto”.

No obstante, Kohli describió el resultado como una “transición de fase” (un cambio transformador) “en el uso de IA en las matemáticas y la capacidad de los sistemas de IA de trabajar en matemáticas”.

El laboratorio les pidió a dos expertos independientes evaluar el desempeño de la IA: Timothy Gowers, matemático de la Universidad de Cambridge en Inglaterra y medallista Fields, quien ha estado interesado en la interacción entre las matemáticas y la IA desde hace 25 años, y Joseph Myers, desarrollador de software de Cambridge. Ambos obtuvieron una medalla de oro en IMO en su época. Myers presidió este año el comité de selección de problemas y en olimpiadas anteriores fungió como coordinador y juzgó las soluciones de seres humanos. “Me propuse evaluar las demostraciones de la IA de la misma manera que se juzgaron las de los seres humanos este año”, indicó.

Tocar el gong

Tras meses de riguroso entrenamiento, los estudiantes se sometieron a dos exámenes con problemas de álgebra, combinatoria, geometría y teoría de números, tres problemas por día.

La IA que competía con ellos se puso a trabajar en los problemas, casi uno tras otro, en el laboratorio de Londres (los estudiantes no sabían que Google DeepMind participaba en la competencia, en parte porque los investigadores no querían llamar la atención). Los investigadores llevaron el gong a la sala en que se habían reunido para ver trabajar al sistema. “Cada vez que el sistema resolvía un problema, tocábamos el gong en señal de celebración”, relató David Silver, uno de los científicos investigadores.

Haojia Shi, estudiante de China, ocupó el primer lugar y fue el único en la competencia en obtener una calificación perfecta: 42 puntos por seis problemas; cada problema vale siete puntos por la solución completa. El equipo de Estados Unidos obtuvo el primer lugar con 192 puntos; China fue segundo lugar con 190.

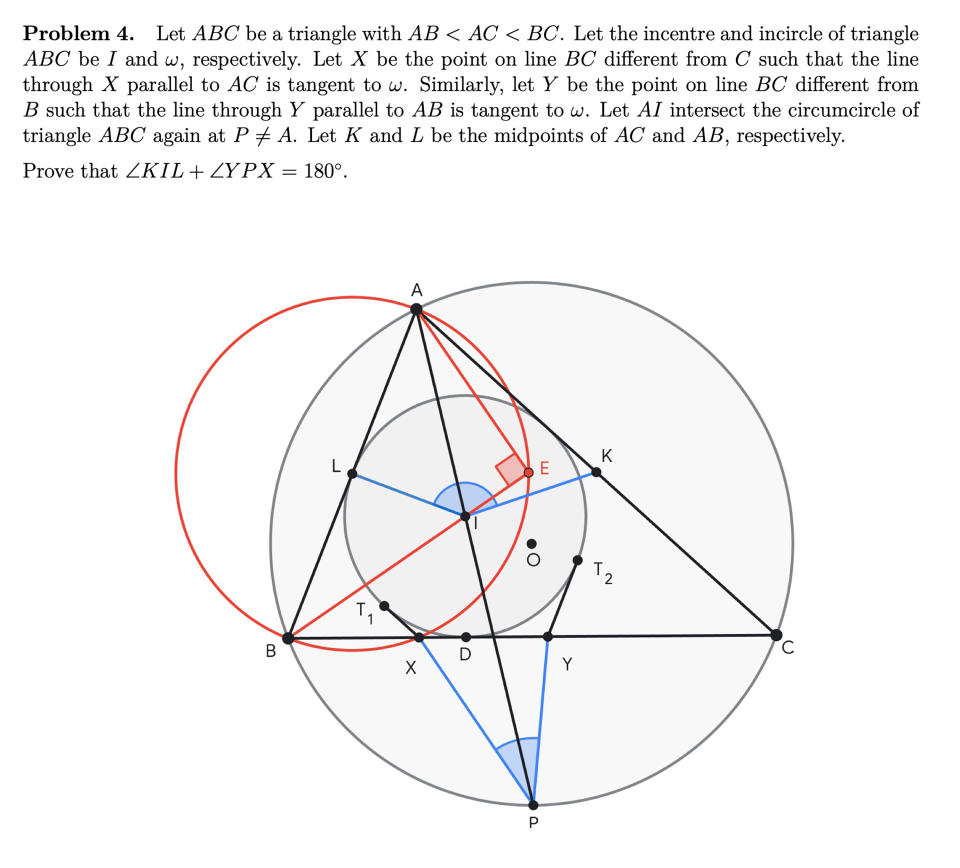

El sistema de Google logró sus 28 puntos por la solución completa de cuatro problemas, dos de álgebra, uno de geometría y uno de teoría de números (no pudo con dos problemas de combinatoria). Al sistema no se le puso ningún límite de tiempo; para algunos de los problemas, tardó hasta tres días. Los estudiantes solo tuvieron 4,5 horas para cada examen.

Ingredientes de algoritmos

Aplicar la IA a las matemáticas ha formado parte de la misión de DeepMind desde hace varios años, por lo regular en colaboración con matemáticos de fama mundial dedicados a la investigación.

“Las matemáticas requieren una combinación muy interesante de razonamiento abstracto, preciso y creativo”, explicó Davies. Hizo notar que, en parte, por este repertorio de habilidades las matemáticas son una buena prueba de fuego para su meta definitiva: alcanzar la llamada inteligencia artificial general, o AGI, por su sigla en inglés, un sistema con un rango amplio de capacidades, desde nivel emergente, pasando por competente y virtuoso, hasta superhumano. Empresas como OpenAI, Meta AI y xAI tienen metas similares.

Los problemas matemáticos de las olimpiadas ahora se consideran un punto de referencia.

En enero, un sistema de Google DeepMind llamado AlphaGeometry resolvió una muestra de problemas de geometría de las olimpiadas casi al nivel de un medallista de oro humano. “AlphaGeometry 2 ya superó a los medallistas de oro en su capacidad para resolver problemas de la IMO”, indicó en un correo electrónico Thang Luong, el investigador principal.

Aprovechando ese ímpetu, Google DeepMind intensificó su trabajo multidisciplinario en torno a las olimpiadas y reunió dos equipos: uno dirigido por Thomas Hubert, ingeniero de investigación de Londres, y otro por Luong y Quoc Le en Mountain View, cada uno integrado por alrededor de 20 investigadores. Para su “equipo de razonamiento superhumano”, Luong afirmó que invitó a más de diez medallistas de la IMO, “¡por mucho, la mayor concentración de medallistas de la IMO en Google!”.

Para las olimpiadas de este año, el laboratorio desplegó la versión mejorada de AlphaGeometry. Así que no es ninguna sorpresa que el modelo haya tenido resultados muy positivos en el problema de geometría, que resolvió en solo diecinueve segundos.

El equipo de Hubert desarrolló un modelo nuevo que es comparable, pero más generalizado. El modelo, AlphaProof, está diseñado para tratar un amplio rango de temas matemáticos. En conjunto, AlphaGeometry y AlphaProof utilizaron muchas tecnologías diferentes de IA.

Un enfoque fue desarrollar un sistema de razonamiento informal, expresado en lenguaje natural. Este sistema aprovechó Gemini, el modelo lingüístico de gran tamaño de Google. Obtuvo datos de entrenamiento del corpus publicado en inglés de problemas, demostraciones y similares.

El sistema informal sobresale en tareas de identificación de patrones y para sugerir qué sigue; es creativo y habla de las ideas de manera comprensible. Por supuesto, los modelos lingüísticos de gran tamaño (LLM, por su sigla en inglés) tienden a inventar cosas, algo que puede funcionar (o no) cuando se trata de poesía, pero definitivamente no sirve cuando se trata de matemáticas. Sin embargo, en este contexto, el LLM parece haberse contenido un poco; no se libró por completo de las alucinaciones, pero aparecieron con una frecuencia mucho menor.

Otro enfoque fue un sistema de razonamiento formal, basado en la lógica y expresado en código. Utilizó un software de demostración de teoremas y prueba interactiva llamado Lean, que garantiza que, si el sistema afirma que una prueba es correcta, entonces de verdad es correcta. “Podemos verificar con exactitud si la demostración es correcta o no”, aseveró Hubert. “Está garantizado que cada paso es perfectamente lógico”.

Otro componente crucial fue un algoritmo de aprendizaje por refuerzo proveniente de AlphaGo y AlphaZero. Este tipo de IA aprende por sí misma y es capaz de escalar indefinidamente, explicó Silver, vicepresidente de aprendizaje por refuerzo en Google DeepMind. Puesto que el algoritmo no necesita un instructor humano, puede “aprender y seguir aprendiendo y seguir aprendiendo hasta que logra resolver los problemas más difíciles que pueden resolver los seres humanos”, dijo. “Y luego, un día, quizá vaya más allá de eso”.

c.2024 The New York Times Company

Yahoo Noticias

Yahoo Noticias